北京大学深圳研究生院邹月娴教授团队在2024年Interspeech国际顶级语音会议斩获最佳论文奖

在2024年国际语音通信协会(ISCA)主办的全球旗舰语音会议Interspeech 2024上,由邹月娴教授带领的现代信号与数据处理实验室(下称ADSP实验室)的研究团队荣获显著成就。Interspeech 2024共录用1029篇学术论文,评选出最佳论文(Best Paper Award)2篇,最佳学生论文(Best Student Paper Award)3篇。ADSP实验室21级辛逸飞同学的论文“DiffATR: Diffusion-based Generative Modeling for Audio-Text Retrieval”荣获Interspeech 2024 最佳论文奖(Best Paper Award);在香港中文大学攻读博士学位的ADSP实验室2023届毕业生杨东超的论文“SimpleSpeech: Towards Simple and Efficient Text-to-Speech with Scalar Latent Transformer Diffusion Models ”荣获Interspeech 2024 最佳学生论文奖(Best Student Paper Award);在约翰霍普金斯大学攻读博士学位的ADSP实验室2022届毕业生王赫麟的论文“Noise-robust Speech Separation with Fast Generative Correction”荣获最佳论文提名奖(Best Paper ShortList)。这一系列研究成果和荣誉的取得获得了语音科技界同行的高度评价与祝贺,充分彰显了ADSP实验室在语音技术前沿研究领域的显著影响力与重要贡献。

本次获得Interspeech 2024最佳论文的“DiffATR: Diffusion-based Generative Modeling for Audio-Text Retrieval”(下简称DiffATR)面向音频-文本检索(Audio-Text Retrieval, ATR)任务开展研究,是机器听觉领域的重要课题。ATR任务旨在输入单模态查询(text or audio query),从目标模态数据库中检索出语义相似的数据实例。ATR在深度学习时代取得了长足进步,但由于跨模态学习方法的局限和缺乏超大规模训练数据集,ATR深度模型尚不能满足商业应用需求。在这项工作中,我们引入了一个生成式基于扩散模型的音频文本检索框架,将音频和文本之间的相关性建模为它们的联合概率,并利用扩散模型从噪声中逐步生成联合概率分布。扩散模型从粗粒度到细粒度阶段的迭代去噪过程使得DiffATR模型能逐步揭示音频和文本之间的相关性,更好地捕捉音频-文本跨模态数据之间的语义关联。此外,我们结合判别式方法利用对比学习来优化缩小语义相关的文本和音频在其表示空间中的差距,帮助扩散模型更好地生成音频和文本的联合分布。在主流标准数据集(AudioCaps和Clotho)上,DiffATR展示了卓越的性能。更值得注意的是,在未采用域外目标数据集微调的情况下,DiffATR在域外数据上也保持了出色的表现,这些实验结果进一步表明了DiffATR技术路线的有效性。DiffATR的研究不仅丰富了ATR领域的研究思路,也为未来使用生成式模型进一步优化ATR的技术发展开辟了新的路径。

邹月娴教授带领的ADSP实验室语音小组一直积极参与语音前沿课题的研究,让机器听懂世界是大家共同的追求,推动AI赋能产业,解决行业痛点是实验室长期的研究目标。

ADSP实验室今日所取得的卓越成就,源于导师与学生间的密切协作,以及团队成员所秉持的坚韧不拔的研究精神、自由探索的学术态度和跨学科合作的开放理念。这种独特的科研氛围不仅激发了创新,更为实验室的持续进步奠定了坚实基础。

在Interspeech这一全球顶尖的语音技术会议上,ADSP实验室的卓越表现不仅展示了团队在语音技术前沿研究领域的最新突破,更大幅提升了北京大学深圳研究生院在国际学术界的声誉和影响力。这一成就无疑将激励ADSP语音团队继续在创新研究和跨界合作中砥砺前行,为推动语音技术的发展做出更多贡献。

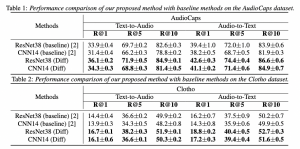

域内数据集检索实验结果

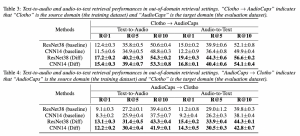

域内数据集检索实验结果 域外数据集检索实验结果

域外数据集检索实验结果